- Русские Блоги

- Python3 Fake_useragent Модуль использования и разрешение ошибок

- Fake_userAgent.

- Fake_useragent Ошибка и решение

- решение:

- fake-useragent 0.1.11

- Navigation

- Project links

- Statistics

- Maintainers

- Classifiers

- Project description

- Features

- Installation

- Usage

- Notes

- Experiencing issues.

- Парсим мемы в питоне: как обойти серверную блокировку

- 1. Вламываемся в мемохранилище

- 1.1. Что мы хотим получить

- 1.2. Что такое HTML

- 1.3. Наш первый запрос

- How to use Python requests to fake a browser visit a.k.a and generate User Agent?

- Question

- 7 Answers 7

- USAGE:

- Как использовать запросы Python для имитации посещения браузера?

- ИСПОЛЬЗОВАНИЕ:

Русские Блоги

Python3 Fake_useragent Модуль использования и разрешение ошибок

При использовании Python, чтобы сделать рептилию, нам нужно замаскировать информацию о голове, чтобы обмануть антизаботающую стратегию веб-сайта, сторонним модулем в Python fake_useragent Очень хорошо решить эту проблему, она вернет случайно упакованную информацию головки, мы можем использовать его напрямую

Fake_userAgent.

Fake_useragent Ошибка и решение

Сообщение об ошибке сообщения:

Сначала определите ключевые отчеты:

Вероятно, значение: этот модуль пытается задать что-то, что достигло максимального количества повторений

Откройте исходный код этого модуля для просмотра обнаружения Эта библиотека будет ссылаться на онлайн-ресурсы, поэтому этот модуль представляет собой данные JSON, которые пытаются запросить веб-сайт несколько раз, а из-за различных причин, запросить время ожидания, поэтому эта ошибка будет сообщена Отказ

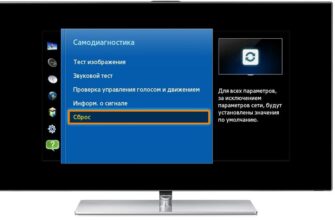

решение:

Первый первый шаг, обновить fake_useragent

1. Укажите несколько параметров при создании присмотра

Отключить кэш сервера

Не покупает данные

Игнорировать проверку SSL

В общем, он может быть решен вышеупомянутым решением, но я более грустный, до сих пор не решал .

2. Используйте временные файлы JSON

В fake_useragent\settings.py Я нашел несколько URL-адресов, некоторые из которых были не могут быть открыты, поэтому мы сможем открыть URL-адрес файла JSON, который будет сохранен локально.

В это время мы получим один 0.1.11 Документ, измените имя файла в fake_useragent_0.1.11.json

Затем найдите наш временный файловый каталог (каждая система отличается, например, ubuntu под / tmp)

Наконец, скопируйте файл во временный каталог.

Когда мы снова создали UserAgent Когда вы впервые прочитаете локальный временный файл, вы не сообщите об ошибке при инстанцировании.

Источник

fake-useragent 0.1.11

pip install fake-useragent Copy PIP instructions

Released: Oct 4, 2018

Up to date simple useragent faker with real world database

Navigation

Project links

Statistics

View statistics for this project via Libraries.io, or by using our public dataset on Google BigQuery

License: Apache Software License

Maintainers

Classifiers

- Development Status

- 5 — Production/Stable

- Intended Audience

- Developers

- License

- OSI Approved :: Apache Software License

- Operating System

- MacOS :: MacOS X

- Microsoft :: Windows

- OS Independent

- POSIX

- Programming Language

- Python

- Python :: 2

- Python :: 3

Project description

| info: | Up to date simple useragent faker with real world database |

|---|

Features

- grabs up to date useragent from useragentstring.com

- randomize with real world statistic via w3schools.com

Installation

Usage

Notes

fake-useragent store collected data at your os temp dir, like /tmp

If You want to update saved database just:

If You don’t want cache database or no writable file system:

Sometimes, useragentstring.com or w3schools.com changes their html, or down, in such case fake-useragent uses heroku fallback

If You don’t want to use hosted cache server (version 0.1.5 added)

In very rare case, if hosted cache server and sources will be unavailable fake-useragent wont be able to download data: (version 0.1.3 added)

If You will try to get unknown browser: (version 0.1.3 changed)

You can completely disable ANY annoying exception with adding fallback: (version 0.1.4 added)

Want to control location of data file? (version 0.1.4 added)

If you need to safe some attributes from overriding them in UserAgent by __getattr__ method use safe_attrs you can pass there attributes names. At least this will prevent you from raising FakeUserAgentError when attribute not found.

For example, when using fake_useragent with injections you need to:

Please, do not use if you don’t understand why you need this. This is magic for rarely extreme case.

Experiencing issues.

Make sure that You using latest version.

Check version via python console: (version 0.1.4 added)

And You are always welcome to post issues

Please do not forget mention version that You are using

Источник

Парсим мемы в питоне: как обойти серверную блокировку

Новогодние праздники — прекрасный повод попрокрастинировать в уютной домашней обстановке и вспомнить дорогие сердцу мемы из 2k17, уходящие навсегда, как совесть Electronic Arts.

Однако даже обильно сдобренная салатами совесть иногда просыпалась и требовала хоть немного взять себя в руки и заняться полезной деятельностью. Поэтому мы совместили приятное с полезным и на примере любимых мемов посмотрели, как можно спарсить себе небольшую базу

данных, попутно обходя всевозможные блокировки, ловушки и ограничения, расставленные сервером на нашем пути. Всех заинтересованных любезно приглашаем под кат.

Машинное обучение, эконометрика, статистика и многие другие науки о данных занимаются поиском закономерностей. Каждый день доблестные аналитики-инквизиторы пытают природу разными методами и вытаскивают из неё сведенья о том, как именно устроен великий процесс порождения данных, создавший нашу вселенную. Испанские инквизиторы в своей повседневной деятельности использовали непосредственно физическое тело своей жертвы. Природа же вездесуща и не имеет однозначного физического облика. Из-за этого профессия современного инквизитора имеет странную специфику — пытки природы происходят через анализ данных, которые надо откуда-то брать. Обычно данные инквизиторам приносят мирные собиратели. Эта статейка призвана немного приоткрыть завесу тайны насчет того, откуда данные берутся и как их можно немножечко пособирать.

Нашим девизом стала знаменитая фраза капитана Джека Воробья: «Бери всё и не отдавай ничего». Иногда для сбора мемов придется использовать довольно бандитские методы. Тем не менее, мы будем оставаться мирными собирателями данных, и ни в коей мере не будем становиться бандитами. Брать мемы мы будем из главного мемохранилища.

1. Вламываемся в мемохранилище

1.1. Что мы хотим получить

Итак, мы хотим распарсить knowyourmeme.com и получить кучу разных переменных:

- Name – название мема,

- Origin_year – год его создания,

- Views – число просмотров,

- About – текстовое описание мема,

- и многие другие

Более того, мы хотим сделать это без вот этого всего:

После скачивания и чистки данных от мусора можно будет заняться строительством моделей. Например, попытаться предсказать популярность мема по его параметрам. Но это все позже, а сейчас познакомимся с парой определений:

- Парсер — это скрипт, который грабит информацию с сайта

- Краулер — это часть парсера, которая бродит по ссылкам

- Краулинг — это переход по страницам и ссылкам

- Скрапинг — это сбор данных со страниц

- Парсинг — это сразу и краулинг и скрапинг!

1.2. Что такое HTML

HTML (HyperText Markup Language) — это такой же язык разметки как Markdown или LaTeX. Он является стандартным для написания различных сайтов. Команды в таком языке называются тегами. Если открыть абсолютно любой сайт, нажать на правую кнопку мышки, а после нажать View page source , то перед вами предстанет HTML скелет этого сайта.

Можно увидеть, что HTML-страница это ни что иное как набор вложенных тегов. Можно заметить, например, следующие теги:

– заголовки разных уровней

– выделения фрагмента документа с целью изменения вида содержимого

| – разделитель для столбцов в таблице Обычно команда открывает тег, а закрывает его. Все, что находится между этими двумя командами, подчиняется правилу, которое диктует тег. Например, все, что находится между — это отдельный абзац. Теги образуют своеобразное дерево с корнем в теге и разбивают страницу на разные логические кусочки. У каждого тега могут быть свои потомки (дети) — те теги, которые вложены в него, и свои родители. Например, HTML-древо страницы может выглядеть вот так: Можно работать с этим html как с текстом, а можно как с деревом. Обход этого дерева и есть парсинг веб-страницы. Мы всего лишь будем находить нужные нам узлы среди всего этого разнообразия и забирать из них информацию! Вручную обходить эти деревья не очень приятно, поэтому есть специальные языки для обхода деревьев.

1.3. Наш первый запросДоступ к веб-станицам позволяет получать модуль requests . Подгрузим его. За компанию подгрузим ещё парочку дельных пакетов. Для наших благородных исследовательских целей нужно собрать данные по каждому мему с соответствующей ему страницы. Но для начала нужно получить адреса этих страниц. Поэтому открываем основную страницу со всеми выложенными мемами. Выглядит она следующим образом: Отсюда мы и будем тащить ссылки на каждый из перечисленных мемов. Сохраним в переменную page_link адрес основной страницы и откроем её при помощи библиотеки requests . А вот и первая проблема! Обращаемся к Попробуем выяснить, почему. Для этого проверим, как выглядел финальный запрос, отправленный нами на сервер, а конкретнее — как выглядел наш User-Agent в глазах сервера. Похоже, мы недвусмысленно дали понять серверу, что мы сидим на питоне и используем библиотеку requests под версией 2.14.2. Скорее всего, это вызвало у сервера некоторые подозрения относительно наших благих намерений и он решил нас безжалостно отвергнуть. Для сравнения, можно посмотреть, как выглядят request-headers у здорового человека: Очевидно, что нашему скромному запросу не тягаться с таким обилием мета-информации, которое передается при запросе из обычного браузера. К счастью, никто нам не мешает притвориться человечными и пустить пыль в глаза сервера при помощи генерации фейкового юзер-агента. Библиотек, которые справляются с такой задачей, существует очень и очень много, лично мне больше всего нравится fake-useragent . При вызове метода из различных кусочков будет генерироваться рандомное сочетание операционной системы, спецификаций и версии браузера, которые можно передавать в запрос: Попробуем прогнать наш запрос еще раз, уже со сгенерированным агентом Замечательно, наша небольшая маскировка Источник How to use Python requests to fake a browser visit a.k.a and generate User Agent?I want to get the content from this website. If I use a browser like Firefox or Chrome I could get the real website page I want, but if I use the Python requests package (or wget command) to get it, it returns a totally different HTML page. I thought the developer of the website had made some blocks for this. QuestionHow do I fake a browser visit by using python requests or command wget? 7 Answers 7FYI, here is a list of User-Agent strings for different browsers: As a side note, there is a pretty useful third-party package called fake-useragent that provides a nice abstraction layer over user agents: Up to date simple useragent faker with real world database Try doing this, using firefox as fake user agent (moreover, it’s a good startup script for web scraping with the use of cookies): USAGE:The root of the answer is that the person asking the question needs to have a JavaScript interpreter to get what they are after. What I have found is I am able to get all of the information I wanted on a website in json before it was interpreted by JavaScript. This has saved me a ton of time in what would be parsing html hoping each webpage is in the same format. So when you get a response from a website using requests really look at the html/text because you might find the javascripts JSON in the footer ready to be parsed. Источник Как использовать запросы Python для имитации посещения браузера?Я хочу получить контент с указанного ниже веб-сайта. Если я использую браузер, такой как Firefox или Chrome, я могу получить настоящую страницу веб-сайта, которую хочу, но если я использую пакет (или wget команду) запросов Python для ее получения, он возвращает совершенно другую HTML-страницу. Я думал, что разработчик веб-сайта сделал для этого несколько блоков, поэтому вопрос: Как подделать посещение браузера с помощью запросов python или команды wget? К вашему сведению, вот список строк User-Agent для разных браузеров: В качестве примечания, существует довольно полезный сторонний пакет под названием fake-useragent, который обеспечивает хороший уровень абстракции над пользовательскими агентами: Современный простой пользовательский агент-фейкер с реальной базой данных если этот вопрос все еще актуален Попробуйте сделать это, используя firefox как поддельный пользовательский агент (более того, это хороший сценарий запуска для парсинга веб-страниц с использованием файлов cookie): ИСПОЛЬЗОВАНИЕ:Корень ответа заключается в том, что человеку, задающему вопрос, необходим интерпретатор JavaScript, чтобы получить то, что ему нужно. Я обнаружил, что могу получить всю необходимую информацию на веб-сайте в json до того, как она будет интерпретирована JavaScript. Это сэкономило мне массу времени при анализе html в надежде, что каждая веб-страница будет в одном формате. Поэтому, когда вы получаете ответ от веб-сайта с использованием запросов, действительно посмотрите на html / text, потому что вы можете найти javascripts JSON в нижнем колонтитуле, готовом для анализа. Источник |

главному источнику знаний и выясняем, что 403-я ошибка выдается сервером, если он доступен и способен обрабатывать запросы, но по некоторым личным причинам отказывается это делать.

главному источнику знаний и выясняем, что 403-я ошибка выдается сервером, если он доступен и способен обрабатывать запросы, но по некоторым личным причинам отказывается это делать. сработала и обманутый сервер покорно выдал благословенный 200 ответ — соединение установлено и данные получены, всё чудесно! Посмотрим, что же все-таки мы получили.

сработала и обманутый сервер покорно выдал благословенный 200 ответ — соединение установлено и данные получены, всё чудесно! Посмотрим, что же все-таки мы получили.