- URL-Фильтр Контента на Роутере D-Link — Блокировка Сайтов

- URL-фильтр D-Link — как запретить доступ к определенному сайту?

- Записки IT специалиста

- Squid — настраиваем URL-фильтрацию по спискам.

- Как мы писали URL-фильтрацию Ростелекому

- DPI и блокировка по IP

- ПО управления фильтрацией

- Поворот трафика и фильтрация

- Как настроить фильтры url

URL-Фильтр Контента на Роутере D-Link — Блокировка Сайтов

Владельцы роутеров D-Link находятся в списке тех счастливчиков, у которых в стоковой прошивке имеется встроенный интернет-фильтр контента, представленный в понятной для новичков форме. Использование блокировщика сайтов, чтобы они не открывались в браузере на компьютере, — весьма действенный способ ограничить доступ к нежелательным материалам в интернете пользователей, подключенных к WiFi сети.

URL-фильтр D-Link — как запретить доступ к определенному сайту?

Для того, чтобы настроить фильтр сайтов на роутере D-Link выполняем следующие шаги:

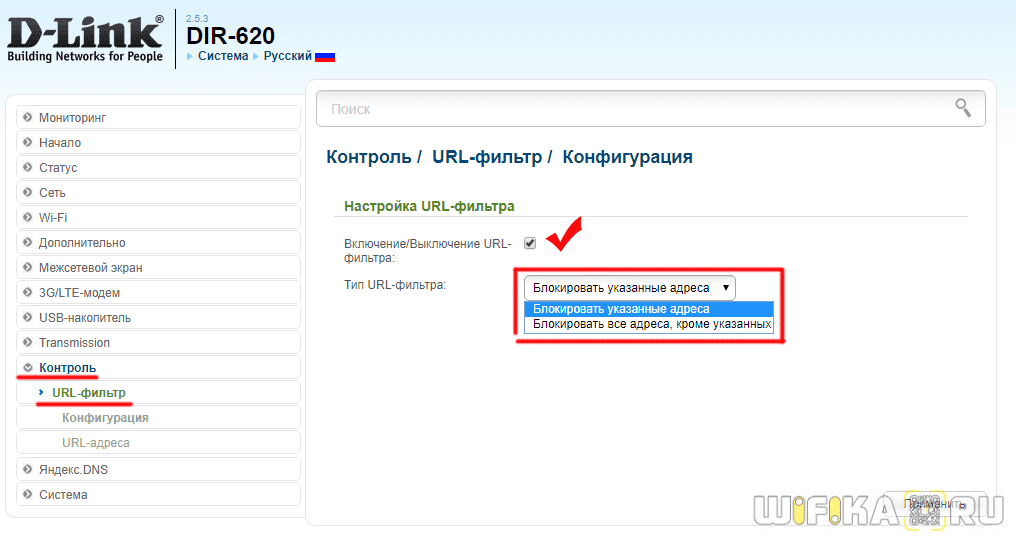

В левом меню открываем раздел «Контроль — URL-фильтр». Здесь ставим галочку на «Включение/выключение URL-фильтра» и выбираем тип фильтрации — будем блокировать прописанные в настройках сайты, или наоборот, блокировать все, кроме указанных

Переходим во второй подраздел «URL-адреса» и добавляем те, которые хотим забанить — ВКонтакте, Одноклассники, Facebook и все остальное, что там еще мешает работать.

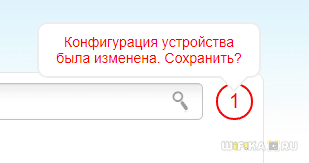

После этого нажимаем кнопку «Применить» и потом еще кликаем на красный значок вверху для полного сохранения конфигурации.

Для запрета посещения тех или иных ресурсов в сети также рекомендую использовать еще одну встроенную функцию — Яндекс DNS. Ее использованию совместно с маршрутизаторпми Д-Линк у меня посвящена ещё одна подробная публикация на блоге.

Если же боитесь сделать что-то не так и что после применения УРЛ фильтра заблокируются какие-то нужные сайты, то можно предварительно попробовать свои силы на эмуляторе роутеров D-Link. После виртуального создания правил ограничения, когда поймете, как это работает, можно будет перейти уже непосредственно к практике.

Источник

Записки IT специалиста

Технический блог специалистов ООО»Интерфейс»

- Главная

- Squid — настраиваем URL-фильтрацию по спискам.

Squid — настраиваем URL-фильтрацию по спискам.

Метод «черных» и «белых» списков идеально подходит для ограничения доступа к ресурсам, адреса которых заранее известны, но по какой-либо причине являются нежелательными, например социальные сети. По сравнению с контентной фильтрацией такой способ имеет множество недостатков, но с другой стороны он гораздо проще в реализации и требует гораздо меньше вычислительных ресурсов.

Эффективность данного метода следует рассматривать с точки зрения поставленной задачи, так если требуется заблокировать для сотрудников соцсети и ряд развлекательных ресурсов, на которых они проводят больше всего времени, то фильтрация по URL-спискам способна полностью решить эту проблему. В тоже время такая фильтрация окажется малоэффективной, если нужно ограничить доступ к любым ресурсам определенного содержания.

В дальнейшем мы будем подразумевать, что читатель обладает начальными навыками администрирования Linux. Также напомним, что все приведеные ниже команды следует выполнять от супрепользователя.

Прежде всего создадим файл списка. Располагаться он может в любом месте, но будет логично разместить его в конфигурационной директории squid — /etc/squid (или /etc/squid3 если вы используете squid3)

и приступим к его заполнению. При указании URL следует использовать RegExp синтаксис, мы не будем подробно останавливаться на этом вопросе, так как это выходит за рамки статьи, подробнее с правилами RegExp можно ознакомиться здесь. Для примера заблокируем популярные соцсети:

Обратите внимание, точка в RegExp является служебным симоволом и поэтому должна быть экранирована символом \ (обратный слеш).

В конфигурационном файле squid (/etc/squid/squid.conf) создадим acl список, в который включим хосты или пользователей, для которых будет производиться фильтрация.

В нашем случае фильтрация включена для всех хостов в диапазоне адресов 10.0.0.100-199, т.е. мы будем фильтровать интернет только для определенной группы пользователей.

Затем подключим наш список:

Ключ -i указывает на то, что список нечувствителен к регистру.

Теперь перейдем в секцию правил и перед правилом

Еще раз обратим ваше внимание, что все правила в squid обрабатываются последовательно, до первого вхождения, поэтому если мы разместим более общее правило перед более частным, то оно работать не будет. То же самое справедливо и для перекрывающихся правил — сработает самое первое.

Сохраним изменения и перезапустим squid:

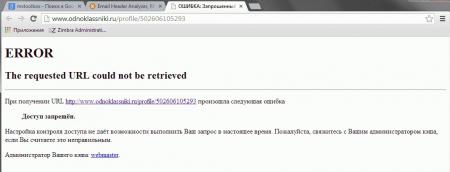

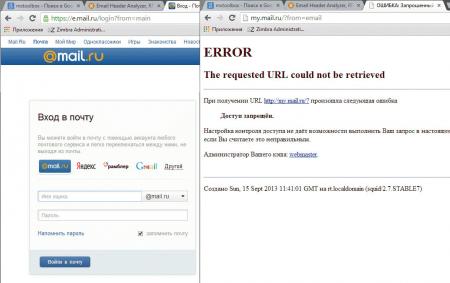

Попробуем посетить сайт из списка, если все сделано правильно, то вы увидите сообщение squid о запрете доступа к данному ресурсу.

Рассмотрим немного иную ситуацию, требуется фильтровать интернет для всех, кроме определенной группы. В этом случае создадим acl для исключенных пользователей:

и изменим запрещающее правило следующим образом:

Также вы можете использовать несколько URL-списков и списков доступа, гибко регулируя доступ для разных групп пользователей.

Вернемся к регулярным выражениям. Допустим, что нам нужно заблокировать не ресурс целиком, а его часть, тогда составим строку таким образом, чтобы она обязательно содержала нужную часть адреса, например строка:

Заблокирует доступ к социальной сети Мой мир, но не будет препятствовать доступу к Майл.ру.

то это приведет к блокировке всех ресурсов, у которых данное сочетание входит в доменное имя, т.е. и mail.ru и hotmail.com. Поэтому к составлению списков, особенно содержащих короткие простые сочетания, нужно подходить осторожно.

Рассмотрим простой, но показательный пример. Допустим нужно заблокировать известный сайт auto.ru и его поддомены. Если мы, не долго думая, напишем

То вместе с требуемым порталом будут заблокированы все сайты имеющие данное сочетание в имени, например abc-auto.ru. Есть о чем задуматься. Если с поддоменами все просто, достаточно написать

и все что содержит точку перед искомым адресом будет заблокировано, то с основным доменом сложнее, самое время вспомнить про полный формат адреса:

Теперь будут заблокированы только адреса начинающиеся с http://auto.ru, конструкция (www\.)? обозначает, что префикс www c точкой могут быть, а могут не быть. Зато другие сайты, содержащие auto.ru будут нормально открываться.

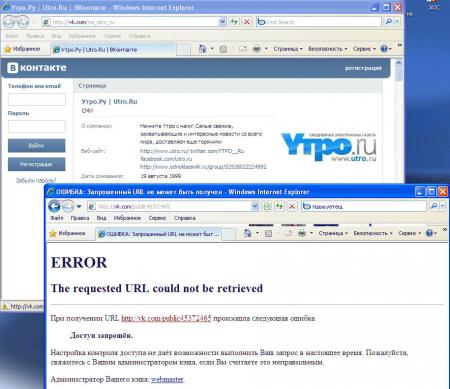

внесем в него нужные адреса, для примера разблокируем страничку Вконтакте новостного портала Утро.ру:

и добавим правило перед запрещающим, в итоге должно получиться:

Так как разрешающее правило расположено раньше, то указанные в «белом» листе ресурсы будут доступны, несмотря на то, что будут попадать под правила «черного».

Источник

Как мы писали URL-фильтрацию Ростелекому

DPI и блокировка по IP

Начать видимо стоит с DPI. Они в некотором количестве на сети имеются, но поставить их на весь трафик стоило бы РТК несколько десятков миллионов долларов и постоянно требовало бы новых инвестиций в связи с ростом потребления скучающим населением. Ни предыдущие, ни теперешние руководители на такое не решились (возможно лишь пока), потому как никаких новых услуг с осязаемыми объемами доходов внедрение DPI не обещает.

Поскольку блокировать разные ресурсы РТК должен был и раньше (суды вершат без оглядки на законы), то и делал это по IP’ческим адресам. Соответственно, простейшая фильтрация на границах решала проблему. Аналогично стали решать и проблему с реестром запрещенных ресурсов: специально обученный человек выгружал реестр, там есть и URL и IP и дальше добавлял записи в списочек, а скрипт правил access list.

ПО управления фильтрацией

Мы автоматизировали общение с реестром и тут, как всем понятно, магии никакой (ее и дальше то особо нет). Запротоколировали внесение изменений в реестре и реализацию цензуры на сети. Добавили мелкие рюшечки, связанные с распределенной структурой ответственности на сети РТК, исключением из действия фильтра части абонентов (в частности запредельных операторов). Ну и суды никто не отменял, поэтому есть возможность внести любой ресурс из судебного решения. Помимо этого, управляющее ПО настраивает перенаправление трафика на узлы фильтрации, готовит отчеты о поисковых запросах пользователей, мониторит узлы фильтрации и протоколирует все активности.

Поворот трафика и фильтрация

Трафик направляемый абонентами на IP адреса соответсвующие блокированным URL’ам на PE поворачивали в специальный VPN, где defult смотрит на пару рутеров в центре. Используя SCU/DCU (похожая функциональность вроде и на кисках имеется) на границе же исключали по адресам источника трафик от абонентов, фильтрации не подлежащих. Софт управления формировал /32 маршруты по IP адресам реестра, правил конфиг на центральном маршрутизаторе и изменения вступали в силу. От посылки BGP апдейтов, помнится, отказались, потому как нехорошо это.

На двух центральных маршрутизаторах настраивали копирование проходящего трафика уже с учетом портов. Соответственно на весь РТК получалось от силы несколько мегабит. Копировать можно было либо на внешний сервер, либо на MS-DPC. И там и там принцип дальнейшей обработки был одинаков. ПО фильтрации ловит пакет, если в нем get с URL’ом из списка, то в сторону сервера шлем сброс, а в сторону браузера редирект на сайт с рассказом про то, как важны моральные принципы для современного российского общества.

Минимальное время ответа от серверов, входивших в реестр год назад, превышало 100 мс, а софтина, анализирующая URL, выдавала ответ за 5-6 мс при нагрузке в 3 Гб/с. Посему решили, что городить прокси, обеспечивать его надежность и прочее в том же духе смысла не имеет. При сбое ПО фильтрации все будет работать, кроме фильтрации понятно. Правда по просьбе РТК запроектировали все равно по паре серверов фильтрации.

Сейчас понятно, что можно было и чуть проще сделать, использовать маленький DPI в центре вместо своего ПО фильтрации. Но так мы уже другому оператору сделали. Может статься, что выбранные внедренцы скомбинируют свое ПО работы с реестром с обычным DPI, через который пойдет только выбранный трафик. Нам же на тот момент хотелось понять есть ли хоть какая-то задача, которую стоило бы реализовывать на сервисных модулях в маршрутизаторе, а не снаружи. То, что Juniper закрыл для внешних разработчиков доступ к модулям, дает четкий ответ на этот вопрос, но нас тогда еще мучили сомнения.

Что касается стоимости, то из того миллиона, о котором идет речь, больше половины составляли серверы, так что большой прибыли на софте там не планировалось.

Источник

Как настроить фильтры url

URL Фильтрация (URL Filtering) — это возможность блокирования WEB-запросов по ключевому слову в адресе (а также возможность задания «черных» и «белых» списков WEB-сайтов).

Каждый URL Filter состоит из набора URL правил, количество которых неограничено. URL правило определяет адрес или часть адреса при нахождении которого в адресе WEB-запроса, данный WEB-запрос будет блокироваться. Например, URL Filter c URL правилами:

будет блокировать доступ ко всем сайтам содержащим в своем имени строки microsoft.com или odnoklassniki.ru

Согласно RFC 3986, адрес WEB-запроса состоит из следующих компонент:

TMeter осуществляет поиск на совпадение URL правила в частях hostname (имя хоста) и/или URI-path (URI-путь) WEB-запроса.

Конструирование URL правил

Помимо простых URL правил, состоящих из частей WEB-адресов (таких как microsoft.com или odnoklassniki.ru), в URL правилах разрешается использование некоторых специальных символов, изменяющих логику поиска на успех совпадения.

определяет, что поиск шаблона URL правила должен осуществляться в начале имени хоста или URI-пути (например, ^forum будет генерировать успех для адреса forum.tmeter.ru, однако для адреса www.forum.tmeter.ru работать не будет)

определяет, что поиск шаблона URL правила должен осуществляться в конце имени хоста или URI-пути (например, .gif$ предотвратит загрузку всех файлов, расширением которых является «.gif»)

соответствует любой комбинации символов, например forum*.ru

Разрешает (не блокирует) адрес, который будет соответствовать шаблону. Данный символ можно применять только в начале шаблона

Комментарий — строка, начинающаяся с этого символа, будет игнорироваться.

Все описанные модификаторы разрешно использовать только один раз в одном URL правиле.

Особенности работы URL фильтрации

URL фильтрация осуществляется в прозрачном режиме (т.е. нет необходимости использовать какой-либо прокси-сервер и специальным образом настраивать браузеры на клиентах). Технология URL фильтрации анализирует каждый TCP пакет на предмет наличия в нем заголовка HTTP-запроса. Если заголовок HTTP-запроса найден в пакете и совпал шаблон URL правила для блокирования сайта, то TMeter формирует ответную HTML-страничку «доступ запрещен» и посылает ее клиенту как бы от имени WEB-сервера. В дополнение, TMeter посылает TCP пакеты с флагом FIN для закрытия TCP-соединения.

Примеры URL фильтров

Запрещает загрузку содержимого с указанных сайтов

Запрещает загрузку всех файлов, расширение которых заканчивается на .js (сценарии javascript), однако разрешает использование javascript на сайтах, в URL-адресе которых встречается слово ‘forum’

Создает «белый» список для сайтов в зонах .ru .com .net и блокирует загрузку всех сайтов из других зон.

- URL Фильтрация не будет работать для сайтов, работающих по протоколу HTTPS

- Для срабатывания URL Фильтрации необходимо, чтобы пакет попал по крайней мере один фильтр для подсчета трафика

- При блокировании сайта технологией URL фильтрации, минимальный интернет-трафик будет зафиксирован фильтром для подсчета трафика, поскольку некоторый трафик требуется для открытия и закрытия TCP соединения

Источник